¿Cuál es el mayor peligro de la Inteligencia Artificial?

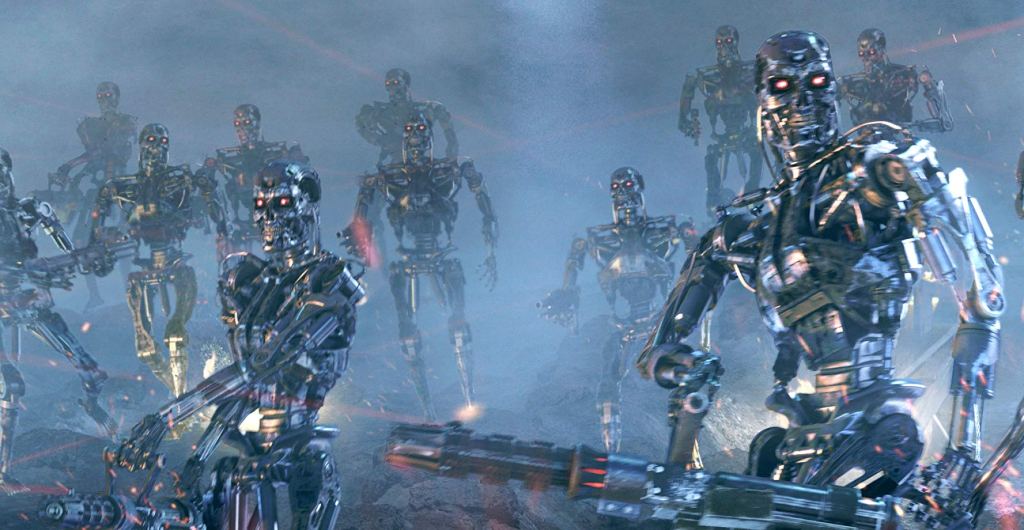

Muchos dirán que el mayor peligro es el despertar de las máquinas a lo Terminator.

Otros dirán que el mayor peligro es la cantidad de puestos de trabajo que van a quitar.

O incluso un futuro tipo Matrix en el que la humanidad sean las baterías de las máquinas:

Otros piensan que el peligro es que nos convierta en imbéciles (¿más?) que tengamos la vida resuelta y no necesitemos esforzarnos para nada. Tipo Wall-E.

Pero esto es mucho futuro y, en tecnología, como en otras muchas cosas, pensar en un horizonte de muchos años, a no ser que sea Isaac Asimov o Julio Verne, es imposible acertar. Pero hay un peligro que ya está entre nosotros y es real, y que con el tiempo puede acentuarse.

Dependencia Excesiva – Overreliance

La dependencia excesiva o Overreliance en la IA se refiere a la tendencia de delegar demasiadas funciones y responsabilidades a los sistemas de inteligencia artificial, confiando en que estas tecnologías tomarán decisiones críticas sin la intervención humana. Esto puede abarcar desde tareas simples, como recomendaciones de productos, hasta decisiones de gran impacto, como diagnósticos médicos o políticas públicas.

Porque, cualquiera que haya jugado con la Inteligencia Artificial, habrá pasado por el estado de «esto es buenísimo» y habrá visto que hay muchas tareas que se pueden delegar en la IA. Y, por supuesto, muchas tareas pueden delegarse y las cosas funcionan. Y cada vez más, pero de ahí a dejar todo el control a una Inteligencia Artificial, hay un salto grande.

Ejemplo – ‘El chatBot descontrolado’

Pongamos un ejemplo, hacemos un chatbot de atención al cliente en nuestra empresa. Al principio y en entornos controlados, todo funciona a las mil maravillas. Podemos complicarlo todo lo que queramos, que tenga acceso a la Base de Datos, que consulte el estado de Stock, Pedidos, Pagos, etc. Además que pueda comunicarse con el cliente con lenguaje natural. ¿Cuánta gente de call center nos ahorramos? Mucha, pero no hay que pensar en que no tengamos que tener agentes humanos de segunda línea. Si dejamos al cliente sin un segundo nivel de resolución humano, y lo supeditamos todo a la Inteligencia Artificial, corremos el riesgo que las respuestas o los caminos de conversación entre el cliente y nuestra empresa se descontrolen. Todos hemos visto las «alucinaciones» de chatGPT, Copilot, Gemini, etc. que cuando no saben algo, directamente se lo inventan.

Para ello tenemos que entrenar muy bien a nuestro chatbot, acotar mucho su rango de actuación y habilitar una segunda línea de contacto humano a la que pasar la conversación si esta se sale del rango de actuación acotada del chatbot.

Riesgos de la Dependencia Excesiva

Por entrar en materia y mostrar diversas categorías de riesgos que la Dependencia Excesiva (Overreliance) puede traer tendríamos:

Pérdida de Habilidades Humanas

A medida que las máquinas se encargan de más tareas, existe el riesgo de que las personas pierdan habilidades críticas. Un ejemplo actual es la dependencia excesiva en GPS, que hace que nuestro cerebro deje de necesitar fomentar el área de la memoria espacial y las habilidades de navegación y orientación. Lo mismo que pasa con muchas habilidades pre-Internet y pre-Smartphones con la gente que ya nació con estas tecnologías en su vida.

Una mujer belga conduce sin darse cuenta hasta Zagreb por un fallo en el GPS

ElMundo.es

Reducción de la Capacidad Crítica

Confiar ciegamente en los sistemas de IA puede reducir la capacidad de los humanos para cuestionar y verificar decisiones. Esto es especialmente preocupante en áreas como la medicina o la justicia, donde la capacidad de análisis crítico es crucial.

¿Qué está pasando ahora en la educación? Ahora mismo es un reto hacer que los jóvenes hagan trabajos de investigación, análisis y estudio sobre cualquier tema. En la mayoría de los conocimientos, el resultado es lo de menos, lo importante es el camino, y eso es lo que las inteligencias artificiales están quitando de la ecuación. Veo un futuro de mucha gente disfuncional.

International Journal of Educational Technology in Higher Education

En este estudio si bien se sacan como conclusiones algunos beneficios potenciales, como que ChatGPT puede ser útil para mejorar la creatividad en la escritura, proporcionar retroalimentación rápida en la programación y facilitar el aprendizaje individualizado.

También concluye que el uso de la IA trae desafíos y riesgos ya que la dependencia excesiva en estas herramientas puede llevar a una menor participación cognitiva, pérdida de habilidades críticas y problemas de integridad académica. Los estudiantes que dependen demasiado de la IA pueden exhibir una disminución en la retención de memoria y en las habilidades de pensamiento crítico. Vamos, que estamos involucionando.

Fallos Técnicos y Vulnerabilidades

Los sistemas de IA no son infalibles, pueden cometer errores, ser hackeados o fallar debido a problemas técnicos. La dependencia excesiva en estos sistemas puede resultar en catástrofes cuando ocurren fallos inesperados. No te quiero contar lo que pasa en mi casa cuando se va Internet, no puedo ni encender las luces.

Apagón de millones de bombillas inteligentes: así fue la caída de Smart Life

ElEspañol.com

Deshumanización de Servicios

La implementación de IA en servicios como la atención al cliente puede llevar a una experiencia deshumanizada. Las máquinas, a diferencia de los humanos, carecen de empatía y comprensión contextual, lo que puede afectar negativamente la calidad del servicio. El ejemplo del «chatBot descontrolado» es un ejemplo de esto. Además también revisa si puedes el artículo de ‘El test de Turing’.

Decisiones Sesgadas

Las IA pueden perpetuar sesgos presentes en los datos con los que fueron entrenadas. Si dependemos demasiado de estas tecnologías sin supervisión adecuada, podemos reforzar y amplificar las desigualdades y discriminaciones existentes. El ejemplo básico es, si una IA es entrenada con los datos históricos pensará que los doctores son siempre hombres, las enfermeras mujeres y Alemania un país que crea Guerras mundiales.

También aquí juega el «Sesgo de Confirmación» (tendencia a buscar, interpretar y recordar información que confirme nuestras creencias preexistentes, mientras se ignora o se minimiza la evidencia contraria.) Por el cual el usuario/humano puede buscar en la IA las respuestas que refuercen su propio sesgo, amplificándolo.

Confianza en Resultados Incorrectos

La sobredependencia puede llevar a aceptar sin cuestionar resultados incorrectos, lo que puede ser particularmente peligroso en campos como la medicina y la justicia, donde los errores pueden tener consecuencias severas. A mi me ha dicho ChatGPT que, con lo que le he dicho, estoy embarazado, ya le he puesto nombre y todo.

Conclusión

Y lo de los futuros distópicos de rebelión de las máquinas como Terminator o Matrix no va a pasar, porque se lo he preguntado a ChatGPT y me ha dicho:

Un comentario sobre “El mayor peligro de la IA”